De Asimov a Tesla: la ética de los algoritmos

¿Qué impacto tiene la ética en la construcción de un sistema de IA? ¿Por qué es imporante para una compañía que sus algoritmos sean éticos?

Isaac Asimov, uno de los más prolíficos escritores de ciencia ficción de la historia, simplificó el comportamiento ético de la inteligencia artificial en tres leyes que buscaban salvaguardar la seguridad de la humanidad. Son sus famosas 3 leyes de la robótica, que forman una parte troncal de su obra y dan pie al desarrollo de muchos de sus relatos. Ciencia ficción pura… hasta hace unos años. La ética de los sistemas de inteligencia artificial ya es una cuestión de estudio teórico, pero también clave a la hora de diseñar un nuevo sistema, y no sólo por una cuestión moral, sino también por las repercusiones reputacionales o legales que puede tener un algoritmo de IA que vulnere unos mínimos principios éticos.

Qué entendemos por ética en el contexto de la IA

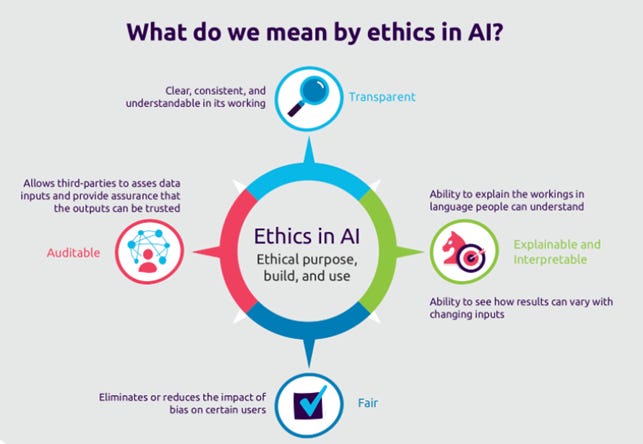

Cuando hablamos de algoritmos de inteligencia artificial, podemos entender la ética a tres niveles distintos: construir sistemas con un propósito ético, de un modo ético y que tengan un comportamiento ético.

Que un sistema inteligente tenga un comportamiento ético implica que pueda ser auditados, que sea transparente y explicable, y que sea justo en sus respuestas. Esto es, que no introduzca o reproduzca sesgos, en especial contra grupos desfavorecidos según alguna categoría protegida (es decir, variables especialmente sensibles como el sexo).

La cuestión de los sesgos es especialmente relevante en el ámbito de muchos negocios. Por ejemplo, en sectores regulados para evitar cualquier tipo de discriminación por sexo o racial, como puede ser el de los seguros, sería completamente intolerable introducir un sistema de pricing basado en un algoritmo de inteligencia artificial que siempre ofreciera un mejor precio a hombres que a mujeres (o al revés). Por tanto, los algoritmos deben ser justos, y esa justicia se puede alcanzar por varias vías:

Evitar, directamente, el uso de las categorías protegidas, es decir, a la hora de entrenar un algoritmo, no utilizar datos que puedan considerarse sensibles. Un modelo no puede desarrollar un sesgo por edad, si no integra la variable edad (ni ninguna otra con una correlación directa, por supuesto).

Garantizar la paridad de la clasificación, es decir, que en la muestra que se emplea para entrenar el algoritmo, se encuentren volúmenes similares de casos de cada categoría protegida, incluso aunque esa categoría no se pretenda explotar de forma directa. Un ejemplo desafortunadamente popular de error asociado a esta cuestión fue protagonizado por Google en 2015, cuando su aplicación Photos etiquetó como gorilas a personas afroamericanas. Sus ingenieros identificaron que esto era así porque el volumen de fotos de personas blancas y negras con las que habían entrenado el sistema no estaba correctamente balanceado.

Por último, considerar a los grupos sensibles o protegidos en el momento de la calibración del modelo, y buscar la paridad estadística en los mismos en el resultado final. Esto es, poner especial foco en estas cuestiones a la hora de verificar los resultados de un modelo, y no dar por bueno un sistema de IA que sugiere distintos resultados sobre una población de hombres frente a una de mujeres, por ejemplo. Fallar en este aspecto podría conducir a que los sistemas aprendieran y perpetuaran sesgos actualmente presentes en la sociedad, tal y como se identificó recientemente que ocurría con la publicidad de Facebook, donde anuncios de ciertas ofertas de empleo, tienen más opciones de mostrarse a hombres que a mujeres, y viceversa.

También la transparencia juega un papel crucial en la ética de los algoritmos, en gran parte porque no basta con construir sistemas justos, sino que también hay que ser capaz de demostrar que lo son. Además, cada vez hay una mayor consciencia sobre la importancia de la privacidad de los datos de los usuarios finales, y éstos cada vez más exigen conocer qué información personal suya se utiliza, cómo se utiliza y con qué fin. Estas tendencias podrían acabar llevándonos a modelos de transparencia total, en los que, como usuarios, podamos saber siempre cuáles son los datos que se han usado para dar una recomendación automática, pudiendo incluso excluir el uso de ciertas variables con facilidad.

Otras implicaciones éticas en el uso de la IA

Empezábamos este artículo hablando de las 3 leyes de la robótica de Isaac Asimov, que no tienen tanto que ver con que un algoritmo carezca de sesgos o sea transparente, sino que establecen un código ético en la toma de decisiones de un autómata. Un nivel de abstracción bastante más elevado… pero, ¿nos pilla tan lejos?

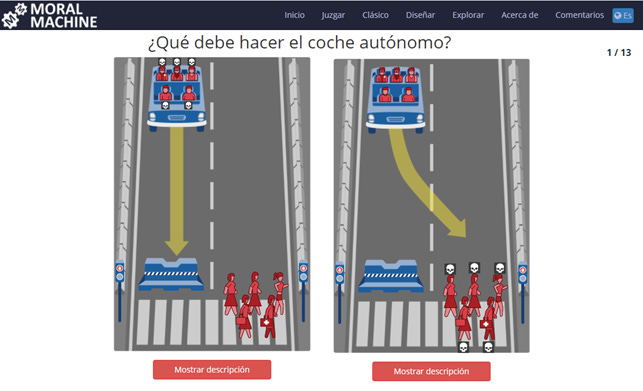

En realidad, no. Hay casos muy concretos en los que ya es necesaria la reflexión de cómo debe comportarse un sistema ante situaciones que planteen un dilema moral. En particular, el coche autónomo. Teóricamente, el coche autónomo debería impactar muy positivamente en la reducción de accidentes de tráfico, como defiende uno de sus principales impulsores, el creador de Tesla, Elon Musk. Sin embargo, eso no significa que los accidentes de tráfico vayan a dejar de existir. Obviamente, la prioridad del sistema de navegación de un coche autónomo, ante un mal funcionamiento, será preservar la seguridad tanto del conductor, como de cualquier otra persona con la que pudiera colisionar, pero, ¿qué ocurre si esto no es posible? ¿Cómo elige el coche si es mejor chocar con una pared o arrollar a un peatón?

Lo interesante del debate es que no hay una respuesta buena, es más, estudios de 2018 apuntan a que las decisiones morales asociadas a este contexto pueden variar mucho de unos países a otros. En 2016, el MIT desarrolló una web (que aún está disponible aquí) para recoger información sobre este tipo de decisiones con un modelo de crowdsourcing, en ella se presentan una serie de escenarios catastrofistas entre los que hay que elegir qué preferirías que hiciera un coche autónomo. Os invito a que probéis a “jugar”, es interesante ver cómo el propio código moral de uno se compara con el global de los miles de usuarios que han alimentado el sistema.

RESUMIENDO

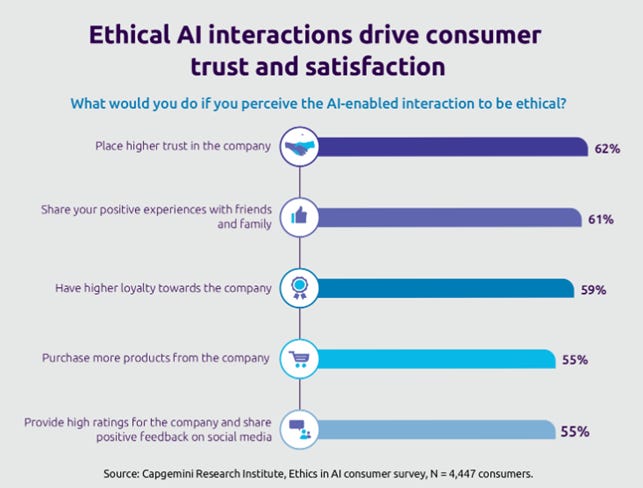

Los aspectos éticos están ya completamente intrincados en el diseño de sistemas de inteligencia artificial, y tienen repercusión en la percepción que se tiene de una compañía y hasta un cierto impacto en el comportamiento de los potenciales clientes frente la misma (lo revela este estudio de CapGemini de 2019). La necesidad de evitar sesgos o de ser transparente es clara, pero otros debates, como el planteado con el coche autónomo, son mucho más complejos y supondrán un reto también a nivel normativo. Igual que es un reto garantizar la ética en el propósito para el que se construyen los sistemas de inteligencia artificial… por ejemplo, lo que se puede llegar a hacer hoy en día con los deepfake da bastante miedo, ¿seremos capaces de crear salvaguardas suficientemente potentes ante las posibles amenazas que puede causar su uso malintencionado? Quien sabe, quizás pronto nos encontremos con nuestra propia versión de las leyes de la robótica formando parte del Código Penal.

Autor: Raúl Melgosa García

🔗 Fuentes:

https://fintechnews.hk/9644/infographic/infographic-ethical-ai/

https://link.springer.com/article/10.1007/s00146-021-01154-8

https://hbr.org/2015/05/customer-data-designing-for-transparency-and-trust